Le talon d'Achille de l'intelligence artificielle : sa consommation d'énergie

L'essor de l'intelligence artificielle (IA) a transformé de nombreux aspects de notre société, de l'industrie à la recherche scientifique. Cependant, cette avancée technologique s'accompagne d'un coût énergétique considérable. Philippe Escande, éditorialiste économique au journal "Le Monde", met en lumière cette problématique dans son article intitulé "Le talon d’Achille de l’intelligence artificielle, c’est sa consommation d’énergie". La question de la consommation d'énergie des centres de données, essentiels au développement de l'IA, se pose avec acuité dans le contexte de la transition énergétique et des efforts pour sortir du charbon.

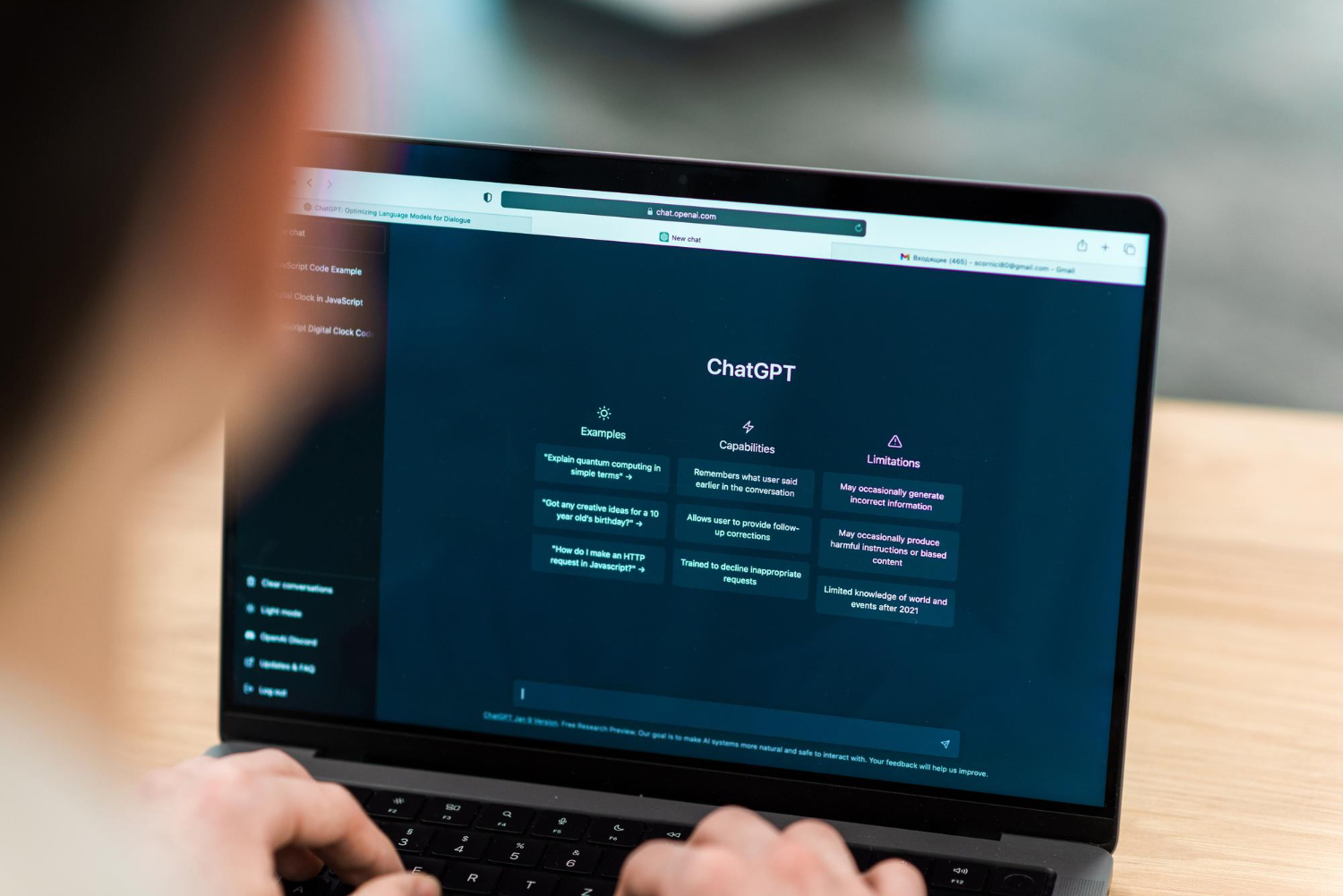

Sam Altman, directeur général d’OpenAI, a souligné ce défi lors du sommet de Davos en janvier dernier. Il a reconnu que la consommation d'énergie est le point faible de l'intelligence artificielle. Altman espère une percée dans la fusion nucléaire, qui pourrait offrir une source d'énergie propre et infinie. Cependant, en attendant cette révolution énergétique, c'est principalement l'énergie produite à partir du charbon qui alimente les besoins croissants de l'IA.

Retards dans la fermeture des centrales à charbon

Depuis le début de l'année, de nombreux producteurs d'électricité aux États-Unis ont annoncé des reports dans leurs projets de fermeture de centrales à charbon. Par exemple, Alliant Energy dans le Wisconsin a repoussé de trois ans la conversion d'une centrale à charbon vers le gaz, tandis que FirstEnergy a reporté son objectif de sortie du charbon au-delà de 2030. Selon une étude de Standard & Poor’s, la réduction de la production d'électricité à partir du charbon sera de 40 % inférieure aux prévisions pour 2023. Ces retards compromettent les objectifs de sortie totale du charbon d'ici 2035 fixés par l'Agence de protection de l'environnement des États-Unis.

La source principale de cette crise énergétique se trouve dans les puces électroniques. Les puces Nvidia, spécialisées dans l'IA, consomment dix fois plus d'énergie qu'un microprocesseur traditionnel. Ainsi, un modèle comme ChatGPT utilise dix fois plus d'énergie que le moteur de recherche de Google. Les géants du numérique, tels que Microsoft, Amazon et Google, investissent massivement dans des centres de données adaptés à cette nouvelle technologie, exacerbant ainsi la demande en électricité.

Exemple de la Virginie du Nord

La Virginie du Nord est l'un des États les plus avancés en termes de centres de données, avec 250 installations consommant déjà 4 000 mégawatts, soit l'équivalent de l'approvisionnement en électricité de 1 million de foyers. Les projets en cours porteront cette consommation à plus de 11 000 mégawatts. Selon le Wall Street Journal, ces centres de données pourraient représenter 9 % de la demande électrique en 2030, soit deux fois plus que les prévisions précédentes.

Enjeux globaux et locaux

Cette situation pose un défi majeur à la transition énergétique. Les efforts pour réduire la dépendance au charbon se heurtent à l'augmentation rapide de la demande en électricité due au développement de l'IA et des technologies numériques. Vingt-cinq États américains ont déjà entamé des procédures contre les objectifs de sortie du charbon, soulignant la complexité de concilier croissance technologique et durabilité environnementale.

L'étude de Philippe Escande révèle les tensions entre le développement de l'intelligence artificielle et les objectifs de transition énergétique. La consommation d'énergie des centres de données représente un défi majeur, nécessitant des solutions innovantes et durables. Alors que le rêve d'une énergie propre et infinie reste à portée de main, il est crucial d'explorer des alternatives et d'optimiser l'efficacité énergétique des infrastructures existantes pour minimiser l'impact environnemental de l'IA.

Source : https://www.lemonde.fr/economie/article/2024/05/31/chatgpt-le-talon-d-achille-de-l-intelligence-artificielle-c-est-sa-consommation-d-energie_6236563_3234.html

La consommation d'énergie de l'IA est un problème majeur car elle augmente la demande en électricité, souvent produite à partir de sources non renouvelables comme le charbon. Cette situation complique les efforts de transition énergétique et les objectifs de réduction des émissions de carbone.

Pour réduire l'impact énergétique de l'IA, il est crucial de développer des technologies plus efficaces sur le plan énergétique, d'investir dans des sources d'énergie renouvelable et de rechercher des innovations comme la fusion nucléaire. Optimiser l'efficacité des centres de données et promouvoir des politiques énergétiques durables sont également des mesures essentielles.

Nos réalisations

Découvrez nos références, nos réalisations et nos travaux pour des établissements.

C'est tout frais de nos experts

Intelligence artificielle dans les EPLE : comment la piloter ?

Spécialités au lycée : les filles moins nombreuses en mathématiques